È il 15 giugno 2020. Amy Goodman, dal suo ufficio di New York, ha appena finito di raccontare di Richard Brooks, 27 anni, ucciso con due colpi di pistola da un agente di polizia ad Atlanta. Brooks stava dormendo nella sua macchina parcheggiata in un posteggio dietro un fast food, quando due poliziotti l’hanno visto e hanno cominciato a battere sulla macchina decisi a sottoporlo all’alcool test. Gli hanno sparato alle spalle mentre scappava a piedi e non era armato. Non è passato neanche un mese dall’omicidio a Minneapolis di George Floyd. Aveva comprato un pacchetto di sigarette con una banconota contraffatta. Un poliziotto, accorso in seguito alla chiamata al 911, gli ha tenuto il ginocchio sul collo per nove lunghi minuti, fino a soffocarlo. Anche Floyd non era armato. Tre mesi fa l’uccisione di Breonna Taylor a Louisville. Colpita da otto colpi di pistola mentre dormiva nel suo letto. Tre poliziotti hanno fatto irruzione nel suo appartamento alla ricerca di stupefacenti, che non hanno trovato. Amy Goodman ha già fatto altri tre nomi di persone che non erano armate quando sono state uccise dalla polizia. Brooks, Floyd, Taylor e le altre tre persone, di cui non mi perdono di aver già perduto il nome, oltre a non essere armate né impegnate in attività per le quali ci si possa aspettare di essere uccisi da un agente di polizia, condividevano un’altra caratteristica: avere due genitori con la pelle nera, circostanza che ha reso anche la loro pelle nera.

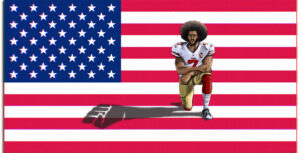

Siamo in lockdown da mesi, e sto seguendo Democracy Now! da Youtube: è un rito di questa quarantena che mi riservo per l’ora di pranzo. Le immagini delle statue dei colonizzatori americani che cadono giù, legati come salumi, si alternano a quelle dei cortei e delle proteste del BLM, fiumi di gente in ginocchio, ovunque nel mondo. Dallo schermo vedo cortei pacifici, e poi riot, e ancora vetrine spaccate, polizia che picchia duro. Non ho ancora capito se l’immagine di quell’edificio in fiamme di Minneapolis sia reale o se sia piuttosto la scena di un disaster movie di Hollywood. Sui social c’è chi dice appartenga al dipartimento di polizia. Diciamo che la mia capacità di discernere il vero dal falso è messa a dura prova dai video che, a giorni alterni, mi manda la zia per sapere cosa pensi delle tesi complottiste sul coronavirus.

In tutto questo caos, oggi dieci accademici, matematici e statistici, hanno mandato una lettera aperta al giornale Notices of the American Mathematical Society: “facciamo appello ai colleghi matematici perché smettano di collaborare coi dipartimenti di polizia […] fornendogli modelli e analisi di dati”. Fonte:Tarik Aougab Non usano mezzi termini, chiedono di smettere di fornire un alibi scientifico a pratiche razziste e oppressive e si riferiscono alla cosiddetta polizia predittiva: l’impiego sempre più diffuso tra i dipartimenti di polizia statunitensi, ma non solo, di metodi statistici e machine learning per predire l’attività criminale prima ancora che avvenga e dirigere così le decisioni su dove e come impiegare il personale delle forze dell’ordine.

Da più di dieci anni matematici, statistici, informatici, lavorano allo sviluppo di tali modelli che vengono poi istruiti a partire da una gran mole di dati provenienti dai database dei dipartimenti di polizia locale. Un poco di criminologia e antropologia tradotte in formule matematiche, un sacco di informazioni raccolte e date in pasto a macchine che, giornalmente, producono le previsioni del crimine, come si fa per il meteo. Dimenticate Minority Report: i crimini in questione non sono rapimenti di bambini né omicidi di partner fedifraghi, né truffe ad opera di grandi imprenditori, né cospirazioni. Nessuna di queste fantasie borghesi. Le previsioni riguardano piuttosto crimini come furti, scippi, scassi, rapine, poi spaccio e uso di droghe, sparatorie legate alle gang: il tipo di reati maggiormente addebitati alle comunità più marginalizzate e razzializzate, quelle a maggioranza black e di latinos.

Ma cosa intendono i matematici nel dire che i modelli statistici e le loro previsioni possano essere razzisti? Per capire di cosa parliamo, dobbiamo aver chiara la nozione di modello statistico e di previsione.

Genesi di un algoritmo razzista

Un modello non è altro che una cosa che si usa per rappresentarne un’altra. Usiamo modelli ogni qualvolta riteniamo una rappresentazione della realtà più utile della realtà stessa. Compriamo il modellino Burago della Lamborghini, di cui incolliamo insieme i pezzi seguendo le istruzioni, perché una Lamborghini vera non ce la potremmo permettere, né potremmo tenerla sul comodino. Usiamo le mappe per navigare i luoghi perché, da fuori, gli spazi li comprendiamo meglio che quando ci stiamo immersi; e in particolare usiamo quelle di Google, perché oltre a indicarci i percorsi, sanno anche stimare quanto tempo impiegheremo per farli. Abbiamo inventato, nel corso della storia, multipli modelli del moto dei pianeti, nel tentativo di spiegare le osservazioni delle stelle che, ogni notte, sorgono ad est e tramontano ad ovest. Insomma, usiamo rappresentazioni della realtà per capirla meglio, per coglierne i tratti fondamentali, per potercela mettere in tasca, per investigarla, per farle domande, per farne previsioni.

Va da sé che ogni rappresentazione può essere realizzata in una grande varietà di modi e dalla scelta di tali modi dipende la qualità della rappresentazione stessa. “Tutti i modelli sono sbagliati, alcuni però sono utili”, diceva lo statistico George Box. Chi fa un modello deve scegliere quanti e quali dettagli rappresentare, quali invece tralasciare e, non meno importante, deve scegliere come relazionarli. L’inventario dei pezzi non basta per montare una macchinina, servono le istruzioni che ci dicano come metterli insieme. Lo sa bene chiunque abbia provato a fare il pane senza una ricetta o con una ricetta sbagliata. Acqua, sale e farina non bastano.

Utilizziamo modelli matematici quando i dettagli scelti per rappresentare la realtà, che chiamiamo variabili, sono tra loro legati in modo quantitativo. In tal caso possiamo lasciare che sia un computer, che è in grado di compiere operazioni molto più velocemente di noi, a riprodurre il modello. Il costo da sostenere è quello di programmare il computer a tale scopo, dato che una macchina non fa nulla che non le venga espressamente comandato. Questo è un algoritmo: un insieme finito di istruzioni che dicono al computer cosa fare, passo dopo passo e senza dare nulla per scontato.

ALGORITMO

Una volta programmato l’algoritmo, guadagniamo la possibilità di eseguirlo tutte le volte che ci va: possiamo cioè simulare il processo che il nostro modello rappresenta e possiamo studiare gli effetti di una modifica delle sue variabili o delle sue leggi quantitative.

Tra i differenti modelli matematici, un modello statistico, in particolare, si serve delle osservazioni quantitative del fenomeno che rappresenta, per farne previsioni oltre che per descriverlo. Per questo si dice che l’algoritmo può apprendere dai dati. È il cosiddetto machine learning, un processo che prevede due fasi. Parte dei dati viene usata per la prima fase, quella di training: si cerca il modo migliore in cui il modello riesca a riprodurli. Il resto dei dati si usa per la fase di testing, nella quale si verifica se tale modo migliore sia in effetti in grado di riprodurre anche i dati nuovi, quelli che il modello non ha visto in fase di training.

Dovrebbe essere chiaro, allora, quante decisioni umane presiedano al processo che porta ad una previsione fatta da un modello statistico. In primis, la scelta delle variabili e delle leggi, che sono come una lente attraverso cui osservare i dati per cercare schemi ricorrenti. Poi la programmazione dell’algoritmo e, infine, la scelta e selezione dei dati sulla base dei quali l’algoritmo produrrà le sue previsioni. E allora, può un algoritmo che prevede il crimine essere razzista quanto o più di un essere umano? La risposta veloce è che se l’algoritmo – che è programmato da esseri umani- o i dati con cui viene istruito – che sono scelti da esseri umani- sono viziati da pregiudizi, c’è grande possibilità che lo siano anche le previsioni che ne risulteranno.

PredPol: l’algoritmo che stigmatizza i quartieri

L’algoritmo di PredPol è stato sviluppato da una matematica e da un antropologo dell’Università della California, in collaborazione con il dipartimento di polizia di Los Angeles. Il modello utilizza appena tre variabili per rappresentare l’attività criminale di una città: il tipo di crimine, quando sia avvenuto e dove. Le leggi del modello che legano tali variabili sono analoghe a quelle che i geologi usano per predire gli eventi sismici, basandosi su quelli già avvenuti. La supposizione di chi ha fatto il modello è che i crimini si diffondano nello spazio e nel tempo come fanno i terremoti: se oggi una casa è stata scassinata, è probabile che presto un’altra nelle vicinanze subirà lo stesso trattamento. I criminologi lo chiamano “repeat victimization” e “near-repeat victimization” e sostengono che valga per i furti, come per lo spaccio e le sparatorie.

Per la fase di apprendimento, l’algoritmo prende i dati in possesso del dipartimento di polizia locale, riguardanti arresti e denunce degli ultimi dieci anni, e applica le regole dei terremoti alla ricerca di schemi che si ripetano, collegando crimini in giorni e località tra loro prossimi. Una volta appresi gli schemi, li utilizza per predire i crimini di oggi sulla base di quelli dei giorni passati.

Così, ogni mattina quando inizia il turno, gli agenti del dipartimento di polizia di Los Angeles ricevono una mappa con gli hot spot predetti dall’algoritmo per il giorno corrente. Si tratta di quadrati, grandi circa quanto mezzo isolato, in cui agli agenti è chiesto di trascorrere il tempo in pattuglia, quando non impegnati a rispondere ad una chiamata. Devono andare negli hot spot e vedere se succede qualcosa, per esempio se colgono un crimine in flagranza. L’idea è anche che la loro presenza nei luoghi hot funzioni da deterrente: chi, intenzionato a rubare una macchina, si accorga di una pattuglia nel circondario, ci penserà due volte. Gli ideatori di PredPol sostengono che indicare ai poliziotti i luoghi a più alto rischio di crimine sia un modo efficiente per ottimizzare l’allocazione delle scarse risorse economiche. Sostengono che, grazie a PredPol, un agente da solo può fare il lavoro di altri sei e, per tale ragione, i dipartimenti di polizia pagano da $10.000 a $150.000 dollari l’anno per il suo utilizzo. Fonte:Puente

Tutti i modelli sono sbagliati, alcuni però sono utili”.

La principale critica mossa a PredPol, d’altra parte, è che legittimi la presenza massiccia di polizia nei quartieri già storicamente presidiati dalle forze dell’ordine, indipendentemente dal fatto che in essi si concentri l’attività criminale più che in altri. In effetti, decenni di ricerca in criminologia hanno mostrato che i dati su arresti e denunce non costituiscono un campione statistico rappresentativo dell’attività criminale. Al contrario, i crimini registrati rappresentano una minima parte di quelli commessi, e sono lo specchio di una discriminazione sistemica verso specifici gruppi etnici, generalmente neri e latinos, e specifici quartieri, generalmente i più poveri e con meno servizi. Fonte:Gelman Fonte:Lange

Sul bias presente nei dati in possesso della polizia influisce anche il rapporto che le varie comunità hanno con la polizia stessa, quanto si sia disposti a chiamarla in aiuto o quanto ci si senta, invece, da essa minacciati. Dati dimostrano che l’utilizzo della forza da parte degli agenti di polizia negli Stati Uniti è molto più diffuso nei confronti di persone nere che non di bianche. Center of Policing Equity riportano che in alcune città la maggior parte delle interazioni tra civili e poliziotti avviene in seguito a chiamate al 911. Tali interazioni finiranno registrate nei database della polizia.

Che i dati in possesso dei dipartimenti di polizia siano affetti da pregiudizi e che PredPol, se istruito con tali dati, generi predizioni che rinforzano tali pregiudizi è stato mostrato elegantemente da Kristian Lum e William Isaac, due statistici dello Human Rights Data Analysis Group, in una ricerca Fonte:Lum effettuata nel 2016. Per prima cosa, hanno confrontato i dati del dipartimento di polizia di Oakland, California, relativi all’uso illegale di droga durante un anno intero con quelli provenienti dall’indagine nazionale sull’uso di droga e salute. I dati della polizia e quelli di salute pubblica raccontano due storie completamente diverse: mentre le stime a partire dai dati pubblici suggeriscono una distribuzione uniforme su tutta la città, anche nelle zone ricche e in quelle a maggioranza bianca, gli arresti sono concentrati in due sole aree, abitate principalmente da cittadini non bianchi e con basso reddito. In tali aree, inoltre, nel giro di un anno, si registrano fino a 200 arresti in più. Ma non finisce qui. Lum e Isaac hanno utilizzato i dati della polizia per istruire l’algoritmo di PredPol e hanno contato quante volte, per ogni giorno dell’anno, l’algoritmo predicesse il verificarsi di un crimine all’interno di un determinato quadrato della città. Piuttosto che mitigare il bias, PredPol lo ha rinforzato indicando i quadrati che erano già maggiormente rappresentati nei dati. Dalla analisi è emerso che, a fronte di un uso di droga proporzionalmente uguale tra bianchi e neri, PredPol avrebbe indicato come target la comunità nera il doppio delle volte di quella bianca.

“Garbage in, garbage out”. Apprendere, ma cosa?

Questa storia è un esempio di come la discriminazione contenuta nei dati possa essere riproposta e rinforzata dalle predizioni di un algoritmo. Tale risultato non deve stupire e dipende da ciò per cui l’algoritmo è stato programmato. Una settimana prima che gli accademici matematici scrivessero la lettera aperta ai loro colleghi, la macchina di Tesla, la Model 3, con in funzione il programma autopilot, si è andata schiantare senza indugio contro un camion ribaltato e fermo da tempo al centro della carreggiata di un’autostrada di Taiwan. L’incidente è stato ripreso dalle telecamere di sicurezza e mostra come la Tesla non abbia accennato a rallentare o a evitare l’ostacolo. Questo è solo l’ultimo di una serie di incidenti, alcuni dei quali mortali, che dal 2016 hanno visto le macchine Tesla in modalità autopilota andare sotto i camion che, per esempio, attraversavano un incrocio. La ragione è che l’algoritmo è stato istruito per riconoscere i tir da dietro o da davanti, proprio come ci si aspetta di incontrarli in autostrada. L’immagine di un tir visto di fianco è una cosa che non esiste nell’universo imparato dalla Tesla, quindi non può essere interpretato come un ostacolo da evitare.

L’algoritmo non contempla un meccanismo che controbilanci il bias nei dati”.

Non è troppo dissimile la storia dell’algoritmo che Amazon aveva impiegato, appena tre anni fa, per automatizzare la selezione del personale. L’azienda lo ha dovuto dismettere quando fu chiaro che il programma aveva imparato a discriminare le donne che si candidassero per posizioni tecniche, come quella di ingegnere informatico. L’apprendimento si era basato sui curriculum degli impiegati e, a quel tempo, la stragrande maggioranza di ingegneri informatici dell’azienda erano uomini. L’algoritmo si è limitato a riprodurre e rinforzare il bias già presente nei dati. Come? Riproducendo le percentuali di uomini e donne ingegnere già presenti in Amazon, e valutando negativamente i college femminili -che nessuno degli attuali lavoratori aveva frequentato- o i curriculum nei quali comparisse il termine “femminile” associato a generiche attività, come in “squadra di rugby femminile”. In effetti all’interno di un curriculum possono esserci altri indizi, oltre la specifica dicitura di genere, che facciano dedurre il genere del proprietario. E ciò aumenta quanto più aumenti la segregazione di genere in una società. Per esempio, in una società che abbia scuole per soli uomini o per sole donne, basterà sapere in che scuola vai per dedurre il tuo genere.

Per lo stesso principio, in città spazialmente segregate come quelle statunitensi, l’indirizzo diventa una buona approssimazione di reddito ed etnia. Basterà sapere dove vivi per conoscere, con buona approssimazione, il colore della tua pelle e le tue disponibilità economiche. PredPol può quindi imparare ad essere razzista e a discriminare i meno abbienti, pur senza mai utilizzare categorie come l’etnia o il reddito.

In effetti, nonostante le equazioni complicate (per gli aficionados, il modello è un sistema di equazioni di reazione-diffusione), PredPol in sostanza predice gli hot spot calcolando una media spaziale dei luoghi in cui il crimine è stato già registrato nei database della polizia. I luoghi previsti per il verificarsi di un crimine, quindi, difficilmente si discosteranno da quelli già noti ai database, specialmente perché l’algoritmo in questione non contempla un meccanismo che controbilanci il bias nei dati, come un’esplorazione random di altre zone. Quindi gli agenti presidiano le stesse zone, ora con la legittimazione di un algoritmo che le ha predette. Così arricchiscono ancor più i database di dati analoghi, rendendo le previsioni sempre più confidenti. Una profezia che si autoavvera, la cui causa risiede nei dati viziati su cui l’algoritmo è stato istruito e nell’algoritmo stesso che, per le sue stesse leggi, non può distanziarsi da tali dati.

Palantir: l’algoritmo che condanna i destini delle persone

Nel luglio del 2013 il comandante della polizia di Chicago bussa alla porta di casa di Robert McDaniel, nella parte ovest della città, in un quartiere noto per lo spargimento di sangue lungo le sue strade. MacDaniel ha 22 anni e non aspettava questa visita. Il comandante è cortese ma ha un messaggio alquanto rude: “Se commetti un crimine ne pagherai le conseguenze massime, senza sconti. Ti teniamo d’occhio”. Aggiunge di avere un fascicolo col nome di Robert sulla propria scrivania, di sapere che lo scorso anno il suo migliore amico sia stato ucciso e lo mette in guardia: “Se non cambi registro, rischi di fare la sua stessa fine”. Robert è alquanto sconvolto. In passato è stato fermato dalla polizia per sospetto di crimini minori ma non ha nessun precedente penale e non è mai stato fermato con un’arma addosso. Fa il genere di cose che fanno i suoi coetanei: fuma erba, a volte scommette soldi ai dadi. Robert ha la pelle nera e pare che la polizia sappia tutto sulla sua vita. Quello che Robert non sa è che il suo nome, frutto di una previsione di un algoritmo, figura tra le 400 persone con i più alti punteggi di rischio di essere coinvolti in sparatorie a Chicago. Si chiamano heat list.

Il modello che ha previsto il nome di Robert, è risultato di una collaborazione tra il dipartimento di polizia di Chicago e l’Illinois Institute of Technology ed il suo sviluppo è stato finanziato dall’Istituto Nazionale di Giustizia per 3.8 milioni di dollari. L’algoritmo non è mai stato reso pubblico. É noto, tuttavia, che, a differenza di PredPol, utilizza moltissime variabili e si basa sul principio proposto da Andrew Papachristos, professore associato di sociologia alla Yale University, per il quale se appartieni ad un giro di persone coinvolte in sparatorie, anche se non vi hai mai partecipato attivamente, sei più a rischio di altri di finirci dentro, come vittima o come carnefice. Il software è stato utilizzato dal 2013 al Novembre del 2019 quando è stato dismesso, in seguito ai dubbi espressi dall’ufficio dell’ispettore generale circa la sua efficacia. Due anni prima, il dipartimento di polizia di Chicago era stato costretto a rilasciare una versione della lista, coi nomi secretati, a seguito della causa intentatagli dal Sun Times. Fino ad allora sia il progetto che l’esistenza stessa delle liste era stato tenuto in gran parte segreto.

L’84% di chi figurava nelle liste dei chronic offender di Los Angeles era afro-americano o latino”.

Liste analoghe di cosiddetti chronic offenders da tenere d’occhio prima che siano coinvolti in una (ulteriore?) sparatoria, sono generate giornalmente in varie città degli States da vari algoritmi. Tra questi, ci sono quelli della compagnia Palantir. La società prende il nome dalle pietre veggenti de Il Signore degli anelli ed ha firmato i suoi primi contratti con le agenzie governative come CIA, FBI e NASA. Voci di corridoio mai confermate sostengono addirittura che Palantir sia stato decisivo per scovare Osama Bin Laden. I contratti con i dipartimenti di polizia sono arrivati dopo e tra i primi dipartimenti a firmarne uno c’è quello di Los Angeles, che ha iniziato a collaborare con Palantir nel 2011.

Come nel caso degli hot spot predetti da PredPol, gli agenti della polizia di Los Angeles ricevono ogni mattina la lista delle persone da tenere d’occhio, perché con i punteggi più alti. Palantir è in grado di gestire e analizzare una immensa mole di dati che ogni giorno vengono integrati nel sistema a partire dalle Field Interview card (FI) e dai lettori automatici di targhe. Le FI sono vere e proprie carte rigide, più o meno della dimensione di uno smartphone: ogni volta che un poliziotto in pattuglia identifichi una persona o una vettura che sembri sospetta, può riempirne una annotandovi ogni tipo di informazione. Ogni nome che compaia in una carta, dal giorno successivo, è nel sistema. I lettori automatici di targhe, invece, utilizzano fotocamere digitali presenti negli edifici pubblici e privati, sui lampioni e perfino sulle auto della polizia, che scattano foto alle macchine in transito. La tecnologia di visione artificiale è in grado di determinare marca, modello e targa dell’auto, non senza errori, alle volte. Non c’è macchina che abbia percorso le strade di Los Angeles, la cui targa non sia stata rilevata da una di queste telecamere (in genere i dati sono conservati per un periodo di tempo che varia tra gli stati, da pochi minuti a parecchi anni ed è successo che siano stati decisivi per risolvere crimini ad anni di distanza).

A partire da questi dati, l’algoritmo calcola i punteggi sulla base della cosiddetta “valutazione di rischio”. Il programma attribuisce un determinato punteggio alle persone che entrano nel sistema. Ogni fermo da parte di un agente ed una scheda compilata, vale un punto. Un arresto con arma, un crimine violento nella fedina penale, il trovarsi in libertà vigilata, l’essere affiliati ad una gang valgono cinque punti. Tale punteggio viene poi integrato con un punteggio previsto, sulla base delle relazioni tra le persone, che l’algoritmo apprende dai dati.

Trovare due variabili che varino congiuntamente, di per sé non è sufficiente per concludere che una causi l’altra. Potrebbe essere puramente un caso”.

Anche in questo caso, sebbene tra il 2009 e il 2018 il dipartimento di polizia di LA abbia investito più di 20 milioni di dollari in Palantir Fonte:Brayne, tra software e hardware, l’attività giornaliera degli agenti in pattuglia non si direbbe abbia subìto cambiamenti significativi. Ogni giorno gli agenti vanno in pattuglia nelle aree note, fermano le persone presenti nelle liste e chi si trovi con loro, il che si traduce in un punto di rischio in più per ciascuno. Per questo motivo gli attivisti della associazione Stop LAPD spying sostengono da anni che il sistema delle liste è il modo per prendere di mira intere comunità, mappare le loro relazioni con lo scopo di smantellarle. Ci sono persone che per il solo fatto di star seduti nella panchina del parcheggio del proprio quartiere, vengono fermati fino a quattro volte in un solo giorno, collezionando così gli stessi punti di chi ha commesso un crimine violento. Per chi vive nei luoghi che sono target della polizia è estremamente facile entrare nel sistema a punti, anche senza aver commesso reati, e, una volta dentro, rimanere bloccati nel circolo vizioso che fa guadagnare punti per una chiacchierata con gli amici.

Un report Fonte:Smith redatto nel 2019 dall’Ispettore Generale del dipartimento di Polizia di Los Angeles Mark Smith sui dati precedenti, riportava che l’84% di chi figurava nelle liste dei chronic offender di Los Angeles era afro-americano o latino. In particolare, un terzo di essi era afro-americano, in una città in cui gli afro-americani rappresentano appena il 9% della popolazione. Inoltre, circa la metà dei chronic offender che figuravano nelle liste non erano mai stati arrestati per possesso di armi e il 10% non aveva mai avuto contatti con la polizia: in entrambi i casi erano dunque il frutto di una previsione. Sembra proprio che anche Palantir abbia imparato ad essere razzista. Le numerose proteste da parte della associazione Stop LAPD spying e di gruppi per la difesa della privacy e delle libertà civili, hanno portato, negli anni, alla sospensione di diversi programmi di polizia predittiva, anche quelli che prevedono le liste di chronic offender. Eppure, Palantir continua ad essere impiegato, oltre che a Los Angeles, in grandi città come New York, New Orleans e Chicago, e i dati collezionati ormai includono anche quelli pubblicati sui social media.

“Correlation is not causation”: correlazione, causalità e previsioni

Caratteristica fondamentale dei modelli statistici è la loro capacità di individuare correlazioni tra le variabili. I modelli statistici sono cioè in grado di ravanare tra immense quantità di dati, che all’occhio umano potrebbero sembrare informi, e scovare le variabili che evolvono in parallelo. Trovano delle forme ricorrenti nei dati.

Trovare due variabili che varino congiuntamente, di per sé non è sufficiente per concludere che una causi l’altra. Potrebbe essere puramente un caso. Oppure potrebbe esserci una terza variabile che non stiamo considerando ma che, in effetti, causi separatamente entrambe.

Scambiare erroneamente la correlazione con la causalità è come dire che il gelato uccida, dopo aver osservato che l’aumento del consumo di gelati sia correlato all’aumento di morti per annegamento in mare. In questo caso è piuttosto facile smascherare la fallacia logica. Non è il gelato a fare annegare, qui c’è in gioco una terza variabile: la temperatura. Il caldo estivo causa separatamente sia l’aumento del consumo di gelati che l’aumento dei bagni in mare. Ed è l’aumento dei bagni a determinare un maggior numero di annegamenti.

Quindi è chiaro a tutti che, allo scopo di salvare vite in mare, non serve vietare i gelati, dovremmo piuttosto eliminare l’estate -se fosse possibile!- oppure impiegare maggior soccorso in mare quando le temperature aumentano. Ecco, scambiare erroneamente la correlazione per causalità crea cortocircuiti, soprattutto quando si prosegue nella fallacia e si assume che la presunta relazione di causalità possa riprodursi in futuro. Così la si usa per fare previsioni. Come nel caso di vietare i gelati.

Insomma, quando si voglia comprendere un fenomeno, la ricerca di correlazioni tra le sue variabili che lo caratterizzano è spesso il miglior punto di partenza. L’importante è chiedersi, dopo averle trovate, se ci sia il meccanismo che spieghi come una variabile causi l’altra e, soprattutto, se tale meccanismo sia stato o possa essere provato.

Volete un esempio di come la comprensione dei meccanismi di causa-effetto sia necessaria per fare previsioni efficaci? Ricordatevi di quella volta che vi siete fermati di notte a guardare le stelle.

Per secoli gli uomini hanno cercato un modello che fosse in grado di comprendere e descrivere le osservazioni della volta celeste. Le stelle ogni giorno sorgono ad est e tramontano ad ovest: lo mostrano bene quelle foto in notturna, ottenute sovrapponendo centinaia di scatti fatti a distanza di pochi minuti, in cui cerchi concentrici bianchi si stagliano sul nero della notte. Durante l’anno, poi, vediamo il sole e la luna spostarsi, percorrendo tutte le costellazioni dello zodiaco. Infine ci sono pianeti come Marte che, nel fare un percorso analogo, compiono due curve a gomito, in uno zig-zag che chiamiamo moto retrogrado.

Queste osservazioni non fanno altro che correlare il moto di stelle e pianeti nel tempo ed il grande astronomo Tolomeo, nel II secolo d.C., aveva trovato un modello che fosse in grado di riprodurle tutte. Aveva messo la terra al centro, il sole e luna che le giravano attorno, e aveva posto i pianeti che fanno zig-zag, come Marte, sui cosiddetti epicicli.

EPICICLO

Un epiciclo è una circonferenza il cui centro è collocato su un’altra circonferenza di raggio maggiore. Tolomeo aveva postulato che Marte si muovesse lungo un cerchio il cui centro ruotasse a sua volta attorno alla terra. La sovrapposizione del moto di un cerchio sull’altro risultava nel moto a zig-zag osservato per Marte dalla Terra.

Il modello di Tolomeo, sebbene fosse in grado di riprodurre fedelmente il percorso dei pianeti osservati, falliva puntualmente nel tentativo di fare predizioni. La ragione è che non spiegava la causa che generasse i fantomatici epicicli né perché sussistessero per certi pianeti e non per altri. Anche i primi modelli eliocentrici, per i quali i pianeti ruotano attorno al Sole, erano in grado di riprodurre le osservazioni senza saperne spiegare le cause.

Fu necessario aspettare quindici secoli da Tolomeo, perché Newton ci spiegasse, con le sue leggi del moto e della gravitazione universale, che i pianeti si muovono attorno al Sole per effetto della forza gravitazionale determinata dalla sua enorme massa. E il modello di Newton, proprio perché descriveva le cause, fu il primo in grado di fare previsioni! Così accadde per Nettuno la cui esistenza fu predetta come necessaria proprio grazie alle leggi di Newton e prima ancora che il pianeta venisse scoperto.

NETTUNO

Ultimo tra pianeti del sistema solare ad essere scoperto, Nettuno è anche l’ultimo in termini di distanza dal sole. Quando Urano, il penultimo, fu scoperto e ne fu osservato il moto, si notò che la sua orbita sembrava violare le leggi di Newton, a meno che non ci fosse un ulteriore pianeta, più distante ancora, che ne perturbasse l’orbita. In effetti, Nettuno fu poi osservato proprio là dove le leggi di Newton predicevano.

Assumersi le responsabilità

E le previsioni generate dai modelli di polizia predittiva? I risultati degli studi in cui si valuta l’impiego dei metodi di polizia predittiva, in varie parti del mondo, sono controversi. Non è chiaro né se le predizioni siano accurate, né se l’implementazione dei metodi sia efficace nel ridurre il crimine. erry Fonte:Meijer Quand’anche le previsioni siano corrette, inoltre, spesso non se ne capisce la ragione, oltre quella già menzionata che i modelli riproducano e rinforzino il bias già presente nei dati. Per non parlare dei casi in cui le previsioni sono scorrette e dei costi incalcolabili che lo stigma comporta nella vita delle persone coinvolte e delle comunità di cui queste fanno parte.

La denuncia dei matematici accademici si riferisce al fatto che le previsioni vengano troppo spesso spacciate come conseguenza di un processo neutrale. Si soprassiede, cioè, sia sulle scelte che sulle responsabilità che presiedono il processo previsionale, nonché sul contesto in cui tali decisioni si inseriscono, ovvero quello di un paese che soffre di un profondo razzismo sistemico.

Il razzismo nei confronti delle minoranze etniche, che oggi si riscontra anche nel bias presente nei dati sui crimini in possesso dei dipartimenti di polizia, ha per secoli fornito la giustificazione allo sfruttamento economico e al controllo e repressione di tali minoranze. È un lungo processo che parte dalle deportazioni di massa, il lavoro schiavile e arriva alle incarcerazioni di massa dei nostri giorni. In tale processo la polizia ha giocato un ruolo fondamentale nel mantenere l’ordine delle cose, come anche la definizione stessa di ciò che, negli anni, è ritenuto criminale o no. Per questo, quando oggi si sceglie di utilizzare quei dati per istruire algoritmi che prevedono i crimini e i potenziali criminali, si prende parte a questo processo.

Non è chiaro né se le predizioni siano accurate, né se l’implementazione dei metodi sia efficace nel ridurre il crimine”.

I matematici, dunque, possono e devono scegliere come posizionarsi e in che direzione agire. Dato l’impatto delle previsioni degli algoritmi, è il caso che i criteri dei programmi siano pubblici, che siano chiari i limiti e gli obiettivi, e infine che il loro impiego sia condiviso e non imposto. Ad oggi, al contrario, la maggior parte degli algoritmi sono di proprietà privata, spesso secretati, ed il loro impiego non sempre è noto ai cittadini. La richiesta, avanzata da anni dalle associazioni di attivisti e ora anche dai matematici autori della lettera, è che “ogni algoritmo con impatti potenzialmente elevati sia sottoposto ad un audit pubblico”.

Programmi di polizia predittiva sono in uso non solo negli Stati Uniti, ma anche in altri paesi tra i quali Messico, Brasile, Cina, Regno Unito. In Italia il programma KeyCrime è utilizzato regolarmente dalla polizia di Milano per predire le rapine di banche ed esercizi commerciali.

L’intelligenza artificiale (AI), quel più largo cappello nel quale rientrano, oltre al machine learning, tutte quelle tecnologie anche più complesse che permettono ad una macchina di emulare il comportamento umano, è destinata ad entrare sempre più nella nostra vita quotidiana ed a migliorarne estremamente la qualità. La regolamentazione del suo uso è un tema attualmente in discussione in Unione Europea. Nel corso del Forum europeo sull’AI 2020, la vicepresidente della commissione europea per le politiche digitali, Margarethe Vestager, ha affermato che le applicazioni dell’intelligenza artificiale a scopi di polizia predittiva non sono accettabili in UE perché potenzialmente discriminatori verso migranti e persone appartenenti a specifici gruppi etnici. Insomma, il dibattito è destinato a crescere e, se all’interno dell’accademia nascono organizzazioni che si dedicano a sviluppare alternative alle pratiche oppressive e razziste, come Data 4 Black Lives, Black in AI o il Center for Policing Equity, per citarne alcune, l’esperienza statunitense mostra chiaramente che il dibattito, per avere risultati, deve appartenere alla cittadinanza. Dobbiamo informarci ed imparare.

In un caotico giugno 2020, una lettera aperta dei matematici è venuta a rompere lo stereotipo dei matematici chiusi nelle loro stanze in penombra, distaccati dal mondo e fissi dietro computer a schermi multipli, in favore di matematici che partecipano e invitano alla partecipazione. E, da matematica, la cosa mi inorgoglisce un po’.